Prenumerera på Kollegas nyhetsbrev

Är du medlem i Unionen? Prenumererar du inte redan på Kollegas utmärkta nyhetsbrev?

Då kan du anmäla dig via länken så får du alla Kollegas bästa nyheter och tips direkt i din inkorg - varje vecka.

Fiffigt va?

Är du medlem i Unionen? Prenumererar du inte redan på Kollegas utmärkta nyhetsbrev?

Då kan du anmäla dig via länken så får du alla Kollegas bästa nyheter och tips direkt i din inkorg - varje vecka.

Fiffigt va?

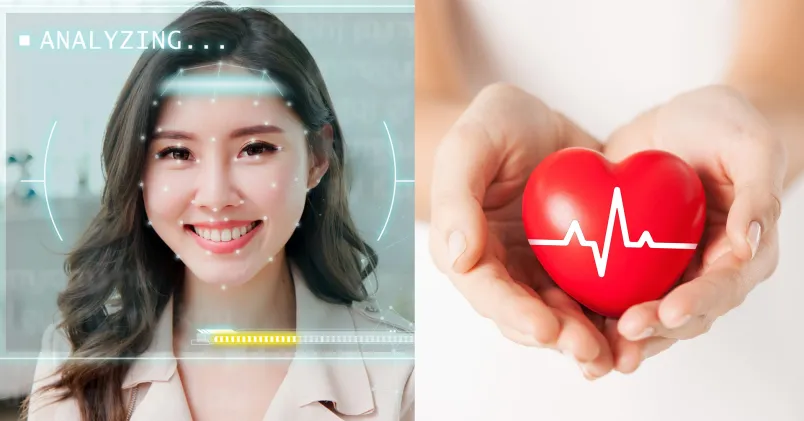

Företaget Framery har utvecklat prototyper av ljudisolerade mötesbås som kan mäta användarens puls och skratt för att skapa ett välmåendindex.

EU har förbjudit emotionell AI på arbetsplatser på grund av integritetsproblem och bristande vetenskapligt underlag.

Framery avslutade sitt projekt "Pulse" efter EU-parlamentets beslut, men ser potential för tekniken inom sjukvård och konsumentprodukter.

Den här sammanfattningen är gjord med hjälp av AI-verktyg och har granskats av Kollegas webbredaktör. Kollegas AI-policy hittar du här.

Det kommer ett mejl till redaktionen. Rubriken lyder: ”AI-kontorspoddar ersätter mötesrum”. Avsändare är det finska bolaget Framery. De ligger bakom en marknadsledande variant av de ljudisolerade mötesbås som har exploderat i popularitet de senaste åren. Båsen är gjorda för att anställda i öppna kontorslandskap ska kunna ha telefon- och videomöten i fred, bland annat. Framery har sålt över 90.000 exemplar till företag som H&M, Astra Zeneca och Microsoft.

Nu vill de visa upp något nytt. Bolagets presskontakt skriver att de har prototypmodeller som kan mäta människors skratt. ”De flesta företag gör ju medarbetarundersökningar någon gång per år men med emotionell AI kan man mycket oftare och löpande få input på medarbetarnas hälsa”, slår han fast.

Kollega har tidigare rapporterat om emotionell AI – en kontroversiell teknik för känsloavläsning som snart är förbjuden på arbetsplatser i hela EU. Politikernas motivering är att tekniken har ett bristande vetenskapligt underlag, men också att den är farlig på just arbetsplatser, eftersom relationen mellan arbetsgivare och anställd är ojämlik.

Europaparlamentet röstade för förbudet 13 mars 2024. Mejlet från Framery kommer två dagar senare. I slutet bjuds vi in till en pressvisning, där vi ska få mer information om ”användningen av emotionell AI på arbetsplatsen”.

Pressvisningen hålls i en ljus lägenhet i centrala Stockholm. Marknadskommunikatören Aron Jahn berättar att Framery har en laboratorieavdelning i Storbritannien. Där finns de modeller som beskrevs i mejlet. De kan mäta användarens puls och skratt, som sedan läggs ihop i en samlad känsloalgoritm.

– Det ger ett gemensamt index på välmående. Vi har testat det själva. Vi såg att stressen gick upp på finansavdelningen under kvartalsslutet, berättar han.

I mina ögon verkar detta tämligen oförsvarbart.

Andrew McStay, chef över forskningscentret Emotional AI Lab vid walesiska Bangor University, reagerar när Kollega berättar om tekniken.

– Som alltid måste saker prövas juridiskt, så det är svårt att säga om något är direkt olagligt. Men i mina ögon verkar detta tämligen oförsvarbart. Det faller in ganska direkt i anledningarna till att EU har utvecklat nya AI-regler.

EU-förbudet innehåller undantag som möjliggör att tekniken kan användas av hälso- och säkerhetsskäl, men hur de undantagen ska avgränsas är inte klart ännu.

I augusti 2024 tar Kollega kontakt med Framery på nytt. Nu hänvisar bolaget till ett annat pressmeddelande. Det är märkt med datumet 16 mars – dagen efter att vi bjöds in till en pressträff om företagets emotionella AI. I den här texten står det i stället att projektet är avslutat.

Marknadskommunikatören Aron Jahn vill inte låta sig intervjuas på telefon, men svarar på frågor via mejl. Där säger han att AI-produkten, som de döpt till ”Pulse”, aldrig var tänkt att användas i verkligheten.

Den 15 mars fick vi ett mejl där ni marknadsförde ert nya projekt med emotionell AI på jobbet. Nu skickar du en länk till ett pressmeddelande daterat den 16 mars, där ni berättar att projektet avslutas. Vad låg bakom den snabba vändningen?

– Tyvärr verkar det som att du har fått föråldrad information från byrån (presskontakten, reds. anm.), skriver Aron Jahn.

Han fortsätter:

– Pulse testades som ett ”proof of concept” internt hos Framery, och även om vi starkt tror på dess potential, anser vi att uppfinningen är olämplig att användas i arbetsmiljöer på grund av potentiella integritetsproblem.

Två dagar före ni skickade inbjudan till oss beslutade EU-parlamentet att förbjuda emotionell AI på arbetsplatser. Är det därför ni har avslutat projektet?

– Nej, vårt beslut grundades i vår övervägning om att mätning av stressnivåer på arbetsplatser strider mot vad vi anser är rätt, även om tekniken ger full anonymitet till användarna.

Men det betyder inte att tekniken är död. I pressmeddelandet som Aron Jahn har länkat till står det: ”Vi tror dock att det kan finnas flera användningsområden för detta i användarprodukter. Vi hoppas att de som är intresserade av den här teknologin tar kontakt med oss.”

När Kollega ber om ett förtydligande svarar Jahn att tekniken bland annat kan användas i sjukvården och för att ersätta så kallade smartklockor.

– Vi tror att tekniken kan vara intressant för konsumentmarknaden, där användarna själva kan erhålla mer exakta stressindikatorer samt mer djuplodande insikter om sin sömnkvalitet och andra hälsorelaterade faktorer utan inledande kalibrering.

Ni skriver också att ni hoppas att de som är intresserade av teknologin tar kontakt med er. Har någon gjort det?

– Nej.

När den här artikeln skrivs har pressmeddelandet om Framery Pulse tagits bort från företagets webbplats. Spåren från testavdelningen i Storbritannien går inte längre att följa. Länken leder i stället till företagets produktsida. Längst upp står det: ”Welcome to the next era of the workplace”.

Det här är del två av tre i Kollegas serie om emotionell AI. Del ett om AI som kan skanna dina känslor kan du läsa här. Del 3, där vetenskapen bakom tekniken ifrågasätts kan du läsa här.

Tre andra företag som skapar emotionell AI

Framery är långt ifrån ensamma om att testa teknikens gränser. Kollega har tidigare rapporterat om svenska Smart Eye, som är ledande inom känsloavläsande AI. Runt om i världen finns andra bolag som gör samma sak. Här är tre exempel.

➧ Cogito (USA): Läser av och analyserar känslouttryck hos callcenterpersonal för att ge automatiserad feedback till de anställda.

➧ Find Solution (Hongkong): Säljer emotionell AI till skolor – alltså datorprogram för att läsa av studenters känslor och uppmärksamhet när de studerar på distans.

➧ Entropik (Indien): Använder kombinerad röst- och ansiktsskanning för att läsa av människors känslor. Har kunder inom detaljhandeln, e-handeln, telekom, med mera.

Nyheter om läckta persondata och datorsystem som slutar att fungera på företag, kommuner och myndigheter kommer allt tätare. Effekterna är oerhört kostsamma, för alla inblandade. De riskerar också att skada förtroendet för företagen som levererar tjänster som hanterar eller har tillgång till känslig information.

Att ha en hög informationssäkerhet blir alltmer betydelsefullt och borde ligga högt på chefers prioriteringslista. När man pratar om att förbättra it-säkerheten brukar dock fokus vara på att utbilda medarbetarna. Sällan ingår det som en del inom ledarskapsutbildningarna.

I ett forskningsprojekt vid Göteborgs universitet inriktat på just det, visade det sig att utbildning riktad till cheferna gav ett bättre resultat på säkerhetskulturen än den som riktas till personalen.

Djävulen sitter i detaljerna

Psykologen Martin Grill, en av forskarna bakom projektet, menar att djävulen som alltid sitter i detaljerna även när det handlar om att öka it-säkerheten.

– Det går inte att prata i allmänna termer om vad man önskar sig, eller ha högt flygande visioner. Man måste vara fokuserad, det har vi sett i ledarutveckling generellt. Om du vill åstadkomma en beteendeförändring så behöver du vara specifik och avgränsad att jobba mot just det.

Alla företag och organisationer har olika förutsättningar och olika styrkor och svagheter och dem måste man identifiera.

– Man får göra riskbedömningar och ha samtal med medarbetarna om vad det finns för hot mot informationssäkerheten, och hur de ska hanteras, säger Martin Grill.

För att sedan öka säkerhetstänket gäller det för chefer att utveckla ledarbeteenden som gör att man sätter det i fokus. Den metod som Martin Grill och hans forskarkollegor har tagit fram inriktar sig på tre beteenden:

Det handlar om att vara specifik när man sätter mål. Om ett företag har identifierat att dokumentationshanteringen har svagheter behöver man ställa frågor kring det. Exempelvis: Vilken typ av dokumentation ska vi hantera och på vilket sätt? Vilka medarbetare ska ha tillgång till den och på vilket sätt? Hur ser vi till att dokumentation inte når fel personer? Utifrån svaren sätts sedan målen.

Enligt Martin Grill gäller det att skapa ett samtalsklimat där det är okej att prata om vilka hot som finns mot it-säkerheten så att chefen får den informationen från medarbetarna.

– För att få veta vad som inte fungerar bra är det viktigt att tänka igenom hur du ska reagera på dåligt säkerhetsbeteende. Om vi bestraffas för att vi berättar hur vi faktiskt gör med vår informationssäkerhet kommer folk inte att vara ärliga.

Följ upp och ge feedback på de mål som ni har satt upp. Om företaget har en krånglig men säker informationshantering som tar lång tid att utföra blir det svårt att få folk att välja den. Det gäller särskilt om det finns ett snabbare sätt men som har lägre informationssäkerhetsnivå. Som chef behöver du därför följa upp och belöna det säkra sättet för att ändra medarbetarnas beteende.

För att veta att säkerhetsbeteendena förändras i positiv riktning är det viktigt att göra mätningar.

– Effekter av mätningar ska man inte underskatta, och det går att mäta mer än man tror. Det är ett väldigt effektivt sätt att följa upp någonting. Det gör att du kan återkoppla bättre.

Martin Grills forskning visar att arbete med it-säkerhet kan ge spridningseffekter.

– Om du till exempel får till en bra rutin i ett projekt tenderar du också att hantera dokumentation säkrare i andra projekt och bli mer noggrann med information generellt. Det leder till beteendeförändringar som sprider sig.

Text: Teres Hallman

1. Sätt upp informationssäkerhet på agendan för ett möte med både chefer och medarbetare.

2. Diskutera vilka problem som finns och hur ni vill hantera dem.

3. Bestäm tid och plats för att ta arbetet vidare.

Obegripliga manualer, datorer som låser sig, nya lösenord som är omöjliga att komma ihåg och teamsmöten som tjorvar. Få saker kan stjäla så mycket tid, framkalla mental härdsmälta och svordomar som när tekniken strular på jobbet.

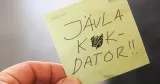

Det är också anledningen till att Unionens vandringsutställning som bygger på medlemmars berättelser om it-strul och som förbundet har tillsammans med Arbetets museum i Norrköping, heter Jävla k*kdator!.

– Det är ett kraftfullt uttryck och några har reagerat. Men igenkänningen är väldigt stor hos de flesta vi möter, säger Annika Sander Welstad från Unionen arbetar med utställningen som ska vandra mellan olika arbetsplatser från södra till norra Sverige.

Digital arbetsmiljö handlar inte bara om utrustning som datorer, skrivare och programvaror, utan också om hur vi mår när vi använder oss av tekniken. För it-strul kostar inte bara enorma pengar utan skapar också onödig stress hos medarbetare

En undersökning från Unionen visar att privatanställda tjänstemän lägger nära 73 miljoner timmar varje år på it-strul. Det generar en kostnad på drygt 31 miljarder kronor per år. Åtta av tio uppger att de i någon utsträckning blir stressade av teknik som inte fungerar, tre av tio blir MYCKET stressade.

Uppgraderingar av nya system, krav på att man ska hänga med och förstå, att kommunicera i flera kanaler och digitala möten som hänger sig är exempel på sådant som skapar stress.

Det senare kan både Linus Nilsson och Martin Falk, som jobbar på Ica Distributions enhet i Helsingborg, skriva under på.

– Jag kan bli frustrerad över när man ska koppla upp sig på Teamsmöten och så går inte kameran i gång. Det finns heller aldrig någon enkel lösning där och då, säger Martin Falk.

Kollegan Linus Nilsson håller med.

– Det kan gå fem minuter av mötet bara att få i gång Teams. Men jag personligen blev stressad av att vi inte kunde enas om vilken kanal vi skulle sprida information på och kommunicera i. Fast det har blivit bättre nu, för att vi nog lärt oss.

De är trots allt nöjda med den digitala arbetsmiljön på jobbet. Visst kan det bli lite stökigt när man till exempel byter olika system, men arbetsgivaren är bra på att tillhandahålla utbildningar för medarbetarna. Den absolut största fördelen tycker de är att arbetsplatsen har en egen it-support på plats, vilket underlättar oerhört.

– Jag kan störa mig på alla uppdateringar och AI stressar mig lite. Men jag springer till supporten när något inte fungerar, där finns alltid någon som hjälper mig, säger Veronika Andersen som också arbetar på Ica i Helsingborg.

De digitala lösningarna utvecklas i snabbt tempo och flera undersökningar visar att medarbetare kan känna oro över att inte hänga med. Men Martin Falk tänker lite tvärtom. Han menar att han i stället har lärt sig vad han inte behöver kunna för att det alltid finns någon annan som kan det bättre. På så vis bli det inte lika övermäktigt, menar han.

Linus Nilsson känner lite annorlunda.

– Jo, visst kan jag känna någon form av stress – jag måste ju hänga med för att vara relevant.