Prenumerera på Kollegas nyhetsbrev

Är du medlem i Unionen? Prenumererar du inte redan på Kollegas utmärkta nyhetsbrev?

Då kan du anmäla dig via länken så får du alla Kollegas bästa nyheter och tips direkt i din inkorg - varje vecka.

Fiffigt va?

Är du medlem i Unionen? Prenumererar du inte redan på Kollegas utmärkta nyhetsbrev?

Då kan du anmäla dig via länken så får du alla Kollegas bästa nyheter och tips direkt i din inkorg - varje vecka.

Fiffigt va?

EU inför ett förbud från februari 2025 mot att använda emotionell AI för att läsa av anställdas känslor på arbetsplatser, på grund av vetenskapliga brister och maktobalans mellan arbetsgivare och anställda.

Det svenska företaget Smart Eye utvecklar emotionell AI som används i olika branscher, inklusive bilindustrin, reklam och medicin. De arbetar nu för att följa de nya EU-reglerna.

Trots förbudet har Smart Eye en vision om att emotionell AI ska kunna användas inom alla områden och branscher, på ett reglerat och avgränsat sätt.

Den här sammanfattningen är gjord med hjälp av AI-verktyg och har granskats av Kollegas webbredaktör. Kollegas AI-policy hittar du här.

Mats Benjaminsson tittar in i en liten, svart kameralins. Hans ansikte dyker upp på en datorskärm. Bredvid honom på skärmen syns ett antal staplar: ilska, förakt, glädje, sorg, förvåning. Ett program läser av hans olika ansiktsuttryck och justerar staplarnas procentvärden. Allt sker löpande, i realtid. Det kallas emotionell AI.

Vi står i uppvisningsrummet hos det göteborgska företaget Smart Eye. De är ledande inom den här tekniken, som kommit att bli kontroversiell. Mats Benjaminsson är bolagets finanschef.

Datorer som kan läsa av känslor har fram till nyligen varit ett ämne för science fiction-författare. Men under de senaste årens AI-boom har det skett en explosiv utveckling av program som kan, eller påstås kunna, göra just det. Tekniken bygger på att övervaka och analysera små förändringar i våra ansiktsrörelser. Algoritmerna har byggts genom att samla in miljontals filmer och bilder av människors ansikten.

Fanny Lyrheden, marknadsansvarig på Smart Eye, visar hur det kan användas i praktiken. Hon sätter sig ned i en bilsimulator i full skala. Vid förarsätet och hos samtliga passagerare sitter kameror. De läser av resenärernas känslor på samma sätt som ovan.

Hon kör runt i en 3D-animerad stadskärna med grå höghus. På just den här simulatorbanan är uppdraget att lämna ett barn på förskolan. Lyrheden beskriver hur bilens datorsystem hanterar informationen från kamerorna.

– Om vi har kört ett tag kan vi få lite statistik. Den följer blicken, var man tittat när man kört, hur mycket man har haft händerna på ratten, säger hon.

– Och även då känslor.

Det är långt ifrån det enda området där Smart Eye vill använda sin teknik.

Medan de här systemen har utvecklats har EU-politiker tagit fram en ny AI-lag. Den förbjuder att AI används för att läsa av anställdas känslor. Ett av motiven är att tekniken anses ha vetenskapliga brister. Ett annat är att det antas råda en ojämn maktbalans mellan arbetsgivare och anställd, och att känsloavläsningsprogram kan vara farliga i det läget.

Förbudet börjar gälla i februari 2025. Det är inte bara själva användandet som stoppas – att sälja emotionella AI-program som ska användas på anställda blir också förbjudet. Undantag kan göras för användning av medicinska skäl och i säkerhetssyfte, men hur de undantagen ska avgränsas är inte klart än.

Vår vision är att emotionell AI en dag ska finnas överallt.

Lagstiftningsarbetet har inte hindrat Smart Eye från att utforska nya branscher. Utöver bilprodukterna säljer de fristående datorprogram med emotionell AI genom två dotterbolag: Imotions och Affectiva. Löftet är att programmen kan läsa av känslor delvis med hjälp av en helt vanlig webbkamera.

Imotions kunder finns inom bland annat flyg-, försvars- och tågindustrin, berättar Mats Benjaminsson. På webbplatsen listas också läkemedelsbolagen GSK och P&G och livsmedelsjätten Unilever.

Affectiva säljer emotionell AI till företag som vill testa hur människor reagerar på deras produkter. På sin webbplats skriver de att ”över 90 procent av världens största reklamköpare” använder deras tjänst. De säljer också ett så kallat utvecklingskit för att hjälpa andra mjukvaruutvecklare föra in emotionell AI i sina program.

Graham Page, högsta chef över Affectivas avdelning för medieanalys, säger i en intervju med Kollega att de dessutom har börjat utforska hur känsloavläsning kan användas i videomötesprogram. På företagets webbplats formuleras en framtidsplan: ”Vår vision är att emotionell AI en dag ska finnas överallt.”

Båda dotterbolagen är helägda av Smart Eye. Mats Benjaminsson är dess näst högsta chef. Vi sätter oss ned i ett konferensrum med utsikt över Göta älv.

EU:s nya AI-förordning förbjuder emotionell AI som används för att läsa av anställdas känslor på jobbet. Hur vet ni att det ni säljer och utvecklar inte bryter mot det förbudet?

– Det som är produktifierat i det här med ”emotion”, det är ju mot ”advertising”-delen. Spelfilmer, trailrar. Nu kan inte jag de detaljerna, men där tänker jag att det finns ett regelverk och att vi följer det.

Han syftar på Affectivas produkter för reklambranschen. Men reklamanalys är alltså långt ifrån den enda emotionella AI-tjänst som Smart Eye-koncernen säljer. Gällande känsloavläsningen i bilar, som Mats Benjaminsson just har visat upp, säger han att bolaget just nu ”sätter sig in i” hur man ska följa de nya EU-reglerna.

Det är ganska kort tid tills förbudet träder i kraft. Från februari nästa år gäller det. Är ni som bolag redo?

– Vi förbereder oss genom att vi har en bolagsjurist.

Mats Benjaminsson berättar att en nyanställd person just nu går igenom Smart Eyes olika affärsavtal.

– Vi är ett litet bolag som vuxit sedan 2021, med de här förvärven (Imotions och Affectiva, reds. anm.), och samtidigt ligger vi i framkant med ny AI-teknik och nya EU-regleringar. Så det är klart att vi har ett jobb att göra. Jag känner inte att vi har en hemläxa, men vi är välbemannade och vi är på frågan.

Emotionell AI är integrerat i det ni säljer genom Imotions. Blir inte det ganska mycket att gå igenom på så kort tid? Där har ni ju många och stora kunder.

– Så är det. Och nu pratade jag faktiskt med vår bolagsjurist precis innan i ett helt annat ärende. Det är klart att vi läser in oss, och det är inte bara vi, det finns ju nätverk och andra advokatbyråer som vi jobbar med. Så i det perspektivet försöker vi hela tiden jobba med dem som ligger i framkant. På så sätt känner jag mig helt trygg.

– Sedan är det klart, det är en stor verksamhet. Det tar ju ändå tid, det får man ha respekt för.

På Affectivas webbplats står det att ”vår vision är att emotionell AI en dag ska finnas överallt”. Varför har ni det målet när EU har bestämt att förbjuda den här tekniken på flera platser för att den anses farlig?

– Jag tror det är så här att den webbplatsen och det påståendet har man nog gjort rent generellt, säger Mats Benjaminsson.

Han söker orden.

– Det har nog funnits där en tid, utan att jag kan det exakta. I och med att vi är ett AI-bolag och vill ligga i framkant så är det klart att …

Fanny Lyrheden fyller i.

– Man kan ju tolka det på flera sätt. Man kan tolka det som att det ska finnas överallt och läsa av allas känslor hela tiden, men det är väl mer så att det ska kunna användas inom alla olika områden och branscher, på ett reglerat och avgränsat sätt. Det är snarare det vi menar.

Så det är Smart Eyes ambition – att emotionell AI ska finnas överallt?

– Grejen är nog så här, att det är nog bara ett ”statement”. Vi vet ju inte riktigt exakt hur AI integreras, lika lite som man visste hur pc:n skulle bli i början på 80-talet, säger Mats Benjaminsson.

Det här är del ett av tre i Kollegas serie om emotionell AI. Del två - om kontorsbås som kan läsa av hur du mår kan du läsa här. Del tre, där den vetenskapliga grunden bakom tekniken ifrågasätts går att läsa här.

Tekniken bygger på att filma ansiktet. En automatisk algoritm läser av små förändringar i ditt minspel, som antas avslöja dina känslor. Algoritmen har tränats genom att samla in miljontals bilder och filmer på människors ansikten. Ibland kompletteras ansiktsavläsningen med till exempel en pulssensor, en mikrofon eller en hjärtfrekvensmätare.

Andrew McStay, chef över forskningscentret Emotional AI Lab på walesiska Bangor University, är skeptisk till teknikens två grundläggande antaganden: att känslor kan delas in i ett fåtal avgränsade kategorier, och att det som pågår inuti en människa kan läsas av genom att snabbt titta på det yttre. I kommande artiklar på Kollega.se berättar han mer.

EU:s övergripande lagpaket om AI är världens första i sitt slag. Det reglerar AI-verktyg utifrån risknivå – ju högre risk, desto större ansvar för den som skapar och använder verktyget. Det som anses allra mest riskfyll blir helt förbjudet. Hit hör bland annat emotionell AI som riktas mot anställda, men även mot skolelever.

Lagen trädde i kraft i augusti 2024, men reglerna börjar gälla med olika fördröjning. Först ut är förbuden, som börjar gälla från februari 2025. Undantag kan tillåtas om produkterna används av hälso- eller säkerhetsskäl. Hur de undantagen ska utformas är i skrivande stund inte klart.

IT-företag grundat 1999 i Göteborg. Har utvecklat en teknik för att spåra ögonrörelser som används i bilars säkerhetssystem. De senaste åren har bolaget riktat in sig på emotionell AI. 2021 köpte de det amerikanska startupföretaget Affectiva, som enligt egen utsago uppfann hela produktkategorin. Samma år köptes också det danska bolaget Imotions.

Koncernen har kontor i bland annat Boston, Singapore och Kairo. Huvudkontoret ligger i Göteborg. Där jobbar omkring 130 personer.

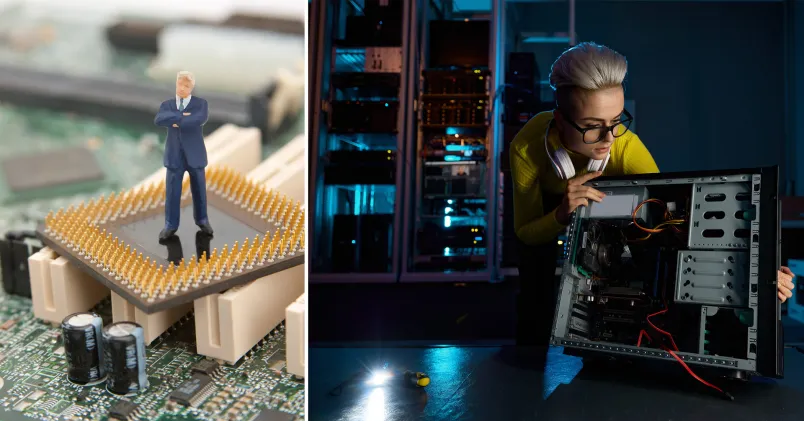

Nyheter om läckta persondata och datorsystem som slutar att fungera på företag, kommuner och myndigheter kommer allt tätare. Effekterna är oerhört kostsamma, för alla inblandade. De riskerar också att skada förtroendet för företagen som levererar tjänster som hanterar eller har tillgång till känslig information.

Att ha en hög informationssäkerhet blir alltmer betydelsefullt och borde ligga högt på chefers prioriteringslista. När man pratar om att förbättra it-säkerheten brukar dock fokus vara på att utbilda medarbetarna. Sällan ingår det som en del inom ledarskapsutbildningarna.

I ett forskningsprojekt vid Göteborgs universitet inriktat på just det, visade det sig att utbildning riktad till cheferna gav ett bättre resultat på säkerhetskulturen än den som riktas till personalen.

Djävulen sitter i detaljerna

Psykologen Martin Grill, en av forskarna bakom projektet, menar att djävulen som alltid sitter i detaljerna även när det handlar om att öka it-säkerheten.

– Det går inte att prata i allmänna termer om vad man önskar sig, eller ha högt flygande visioner. Man måste vara fokuserad, det har vi sett i ledarutveckling generellt. Om du vill åstadkomma en beteendeförändring så behöver du vara specifik och avgränsad att jobba mot just det.

Alla företag och organisationer har olika förutsättningar och olika styrkor och svagheter och dem måste man identifiera.

– Man får göra riskbedömningar och ha samtal med medarbetarna om vad det finns för hot mot informationssäkerheten, och hur de ska hanteras, säger Martin Grill.

För att sedan öka säkerhetstänket gäller det för chefer att utveckla ledarbeteenden som gör att man sätter det i fokus. Den metod som Martin Grill och hans forskarkollegor har tagit fram inriktar sig på tre beteenden:

Det handlar om att vara specifik när man sätter mål. Om ett företag har identifierat att dokumentationshanteringen har svagheter behöver man ställa frågor kring det. Exempelvis: Vilken typ av dokumentation ska vi hantera och på vilket sätt? Vilka medarbetare ska ha tillgång till den och på vilket sätt? Hur ser vi till att dokumentation inte når fel personer? Utifrån svaren sätts sedan målen.

Enligt Martin Grill gäller det att skapa ett samtalsklimat där det är okej att prata om vilka hot som finns mot it-säkerheten så att chefen får den informationen från medarbetarna.

– För att få veta vad som inte fungerar bra är det viktigt att tänka igenom hur du ska reagera på dåligt säkerhetsbeteende. Om vi bestraffas för att vi berättar hur vi faktiskt gör med vår informationssäkerhet kommer folk inte att vara ärliga.

Följ upp och ge feedback på de mål som ni har satt upp. Om företaget har en krånglig men säker informationshantering som tar lång tid att utföra blir det svårt att få folk att välja den. Det gäller särskilt om det finns ett snabbare sätt men som har lägre informationssäkerhetsnivå. Som chef behöver du därför följa upp och belöna det säkra sättet för att ändra medarbetarnas beteende.

För att veta att säkerhetsbeteendena förändras i positiv riktning är det viktigt att göra mätningar.

– Effekter av mätningar ska man inte underskatta, och det går att mäta mer än man tror. Det är ett väldigt effektivt sätt att följa upp någonting. Det gör att du kan återkoppla bättre.

Martin Grills forskning visar att arbete med it-säkerhet kan ge spridningseffekter.

– Om du till exempel får till en bra rutin i ett projekt tenderar du också att hantera dokumentation säkrare i andra projekt och bli mer noggrann med information generellt. Det leder till beteendeförändringar som sprider sig.

Text: Teres Hallman

1. Sätt upp informationssäkerhet på agendan för ett möte med både chefer och medarbetare.

2. Diskutera vilka problem som finns och hur ni vill hantera dem.

3. Bestäm tid och plats för att ta arbetet vidare.

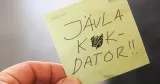

Obegripliga manualer, datorer som låser sig, nya lösenord som är omöjliga att komma ihåg och teamsmöten som tjorvar. Få saker kan stjäla så mycket tid, framkalla mental härdsmälta och svordomar som när tekniken strular på jobbet.

Det är också anledningen till att Unionens vandringsutställning som bygger på medlemmars berättelser om it-strul och som förbundet har tillsammans med Arbetets museum i Norrköping, heter Jävla k*kdator!.

– Det är ett kraftfullt uttryck och några har reagerat. Men igenkänningen är väldigt stor hos de flesta vi möter, säger Annika Sander Welstad från Unionen arbetar med utställningen som ska vandra mellan olika arbetsplatser från södra till norra Sverige.

Digital arbetsmiljö handlar inte bara om utrustning som datorer, skrivare och programvaror, utan också om hur vi mår när vi använder oss av tekniken. För it-strul kostar inte bara enorma pengar utan skapar också onödig stress hos medarbetare

En undersökning från Unionen visar att privatanställda tjänstemän lägger nära 73 miljoner timmar varje år på it-strul. Det generar en kostnad på drygt 31 miljarder kronor per år. Åtta av tio uppger att de i någon utsträckning blir stressade av teknik som inte fungerar, tre av tio blir MYCKET stressade.

Uppgraderingar av nya system, krav på att man ska hänga med och förstå, att kommunicera i flera kanaler och digitala möten som hänger sig är exempel på sådant som skapar stress.

Det senare kan både Linus Nilsson och Martin Falk, som jobbar på Ica Distributions enhet i Helsingborg, skriva under på.

– Jag kan bli frustrerad över när man ska koppla upp sig på Teamsmöten och så går inte kameran i gång. Det finns heller aldrig någon enkel lösning där och då, säger Martin Falk.

Kollegan Linus Nilsson håller med.

– Det kan gå fem minuter av mötet bara att få i gång Teams. Men jag personligen blev stressad av att vi inte kunde enas om vilken kanal vi skulle sprida information på och kommunicera i. Fast det har blivit bättre nu, för att vi nog lärt oss.

De är trots allt nöjda med den digitala arbetsmiljön på jobbet. Visst kan det bli lite stökigt när man till exempel byter olika system, men arbetsgivaren är bra på att tillhandahålla utbildningar för medarbetarna. Den absolut största fördelen tycker de är att arbetsplatsen har en egen it-support på plats, vilket underlättar oerhört.

– Jag kan störa mig på alla uppdateringar och AI stressar mig lite. Men jag springer till supporten när något inte fungerar, där finns alltid någon som hjälper mig, säger Veronika Andersen som också arbetar på Ica i Helsingborg.

De digitala lösningarna utvecklas i snabbt tempo och flera undersökningar visar att medarbetare kan känna oro över att inte hänga med. Men Martin Falk tänker lite tvärtom. Han menar att han i stället har lärt sig vad han inte behöver kunna för att det alltid finns någon annan som kan det bättre. På så vis bli det inte lika övermäktigt, menar han.

Linus Nilsson känner lite annorlunda.

– Jo, visst kan jag känna någon form av stress – jag måste ju hänga med för att vara relevant.